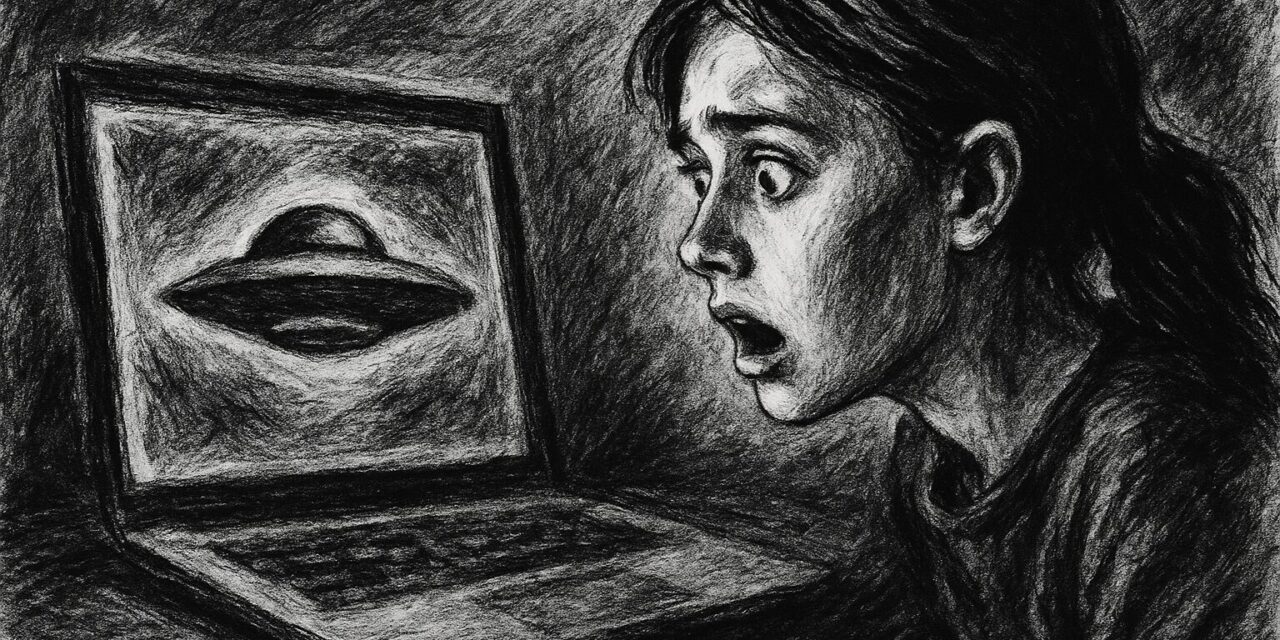

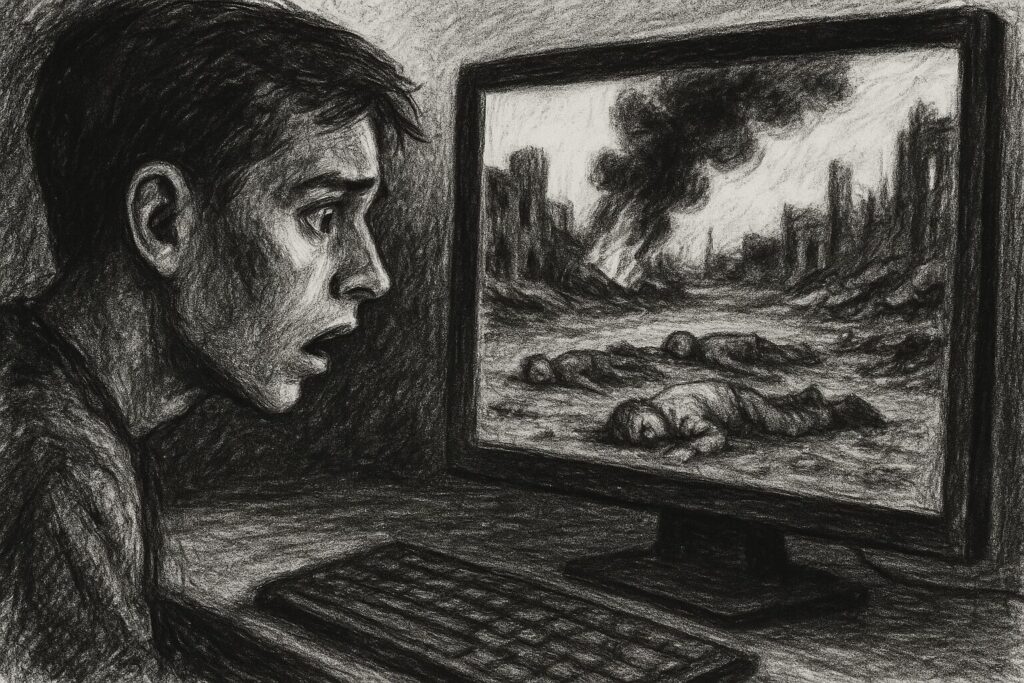

Une enseignante de cinquante-deux ans découvre une vidéo d’elle circulant sur les réseaux sociaux. Son visage. Sa voix. Mais des propos racistes qu’elle n’a jamais prononcés. En quarante-huit heures, sa réputation de trente ans s’effondre. Certains parents réclament son renvoi. Des collègues la fuient. Tout semble réel. Pourtant, rien ne l’est : c’est un deepfake.

Les deepfakes ne sont pas qu’une prouesse technologique. Ils constituent une menace invisible qui érode le socle de notre confiance collective. Quand l’intelligence artificielle forge des imposteurs parfaits, comment distinguer encore l’authentique du fabriqué ?

Qu’est-ce qu’un deepfake exactement ?

Le terme deepfake fusionne « deep learning » (apprentissage profond) et « fake » (faux). Il désigne des contenus audio, vidéo ou photo hyper-réalistes générés ou modifiés par intelligence artificielle pour faire dire ou faire faire à quelqu’un ce qu’il n’a jamais dit ou fait.

💡 DÉFINITION : Deep learning

Technique d’apprentissage automatique où une intelligence artificielle analyse des milliers d’exemples pour apprendre à reproduire des comportements complexes, comme imiter un visage ou une voix.

Exemple : En analysant 500 photos de vous, une IA apprend à recréer votre visage dans n’importe quelle position.

Les premiers deepfakes sont apparus en 2017. D’abord utilisés pour greffer des visages de célébrités sur des contenus pornographiques, ils ont rapidement évolué. Aujourd’hui, la technologie permet de créer des synthèses vocalesindétectables en quelques minutes à partir d’un simple enregistrement vocal de quelques secondes.

Comment sont créés les deepfakes ?

La fabrication repose sur trois étapes. D’abord, la collecte massive de données : photos, vidéos, enregistrements audio de la personne ciblée. Ces contenus constituent la matière première de l’imposture. Ensuite, l’entraînement algorithmique : l’IA analyse ces données pour apprendre les expressions faciales, les intonations vocales, les micro-mouvements caractéristiques. Enfin, la génération du faux : l’algorithme produit un nouveau contenu où la personne semble dire ou faire ce que son créateur souhaite.

Le philosophe Walter Benjamin parlait en 1935 de la « perte de l’aura » de l’œuvre d’art à l’ère de sa reproductibilité technique. Que dirait-il aujourd’hui de la perte de l’aura du réel lui-même ? Notre propre visage, notre propre voix perdent leur authenticité garantie.

Problème central : nous avons nous-mêmes fourni la matière première. Des milliers de selfies sur Instagram, des heures de vidéo sur TikTok, notre voix dans des messages vocaux quotidiens. Un visage qui apparaît cinquante fois en ligne peut être modélisé, recréé, animé pour commettre l’impensable.

Pourquoi les deepfakes fonctionnent-ils si bien ?

Les deepfakes exploitent trois vulnérabilités fondamentales de notre société numérique.

Notre exposition permanente

Nous avons donné nos visages sans compter. Les réseaux sociaux ont transformé chaque utilisateur en producteur involontaire de données d’entraînement pour l’IA. « Je n’avais jamais pensé que mes selfies pourraient servir à ça », confie une victime de deepfake pornographique diffusé dans son entreprise.

Cette surexposition numérique rejoint les enjeux de surveillance dont les sociologues alertent depuis des décennies. Chaque trace laissée en ligne devient potentiellement une arme retournée contre nous.

Notre architecture émotionnelle

Les contenus qui circulent le plus vite sont ceux qui provoquent des émotions fortes : colère, indignation, peur. Les deepfakes les plus viraux confirment nos biais, nourrissent nos préjugés, valident nos craintes. Ils prospèrent sur le terrain fertile de nos divisions sociales.

📊 CHIFFRE-CLÉ

Les contenus émotionnels sont partagés 2,5 fois plus que les contenus factuels neutres (étude MIT, 2023).

Le biais de confirmation joue ici un rôle central. Nous privilégions instinctivement les informations qui confortent nos croyances préexistantes. Si nous nous méfions déjà d’un politicien, le deepfake qui le discrédite semblera plus crédible. Cette dynamique rejoint ce que certains chercheurs appellent l’amnésie collective organisée : notre tendance à reconstruire le passé selon nos grilles de lecture présentes.

L’écosystème algorithmique

Les plateformes numériques construisent des bulles informationnelles personnalisées autour de nous. Si l’algorithme détecte votre méfiance envers une personnalité publique, il vous montrera plus facilement le deepfake qui la discrédite. La personnalisation devient le cheval de Troie de la désinformation ciblée.

« Les algorithmes amplifient ce que nous sommes déjà », écrit le sociologue Dominique Cardon. Ils nous renvoient une image déformée de nous-mêmes, puis nous nourrissent de faux qui ressemblent à nos vérités.

Conséquences sociales : l’ère du soupçon généralisé

Que devient une société qui ne peut plus croire ses propres yeux ?

L’érosion de la confiance collective

Nous entrons dans l’ère du soupçon généralisé. Chaque vidéo, chaque enregistrement audio devient potentiellement suspect. Cette érosion de la confiance n’est pas un dommage collatéral – c’est souvent l’objectif principal des acteurs malveillants qui déploient ces technologies.

Trois cas illustrent cette menace :

L’arnaque vocale : un informaticien crée un faux message vocal d’un PDG ordonnant un virement bancaire urgent. L’entreprise perd 30 000 euros. « Je ne pensais pas que ça marcherait vraiment », avoue-t-il après sa condamnation à six mois avec sursis.

L’infiltration professionnelle : une « experte en cybersécurité » apparaît sur LinkedIn en 2023. Profil crédible, connexions multiples, analyses pertinentes. Six mois plus tard, une enquête révèle qu’elle n’existe pas. Son visage : un deepfake. Son objectif : collecter des informations sur des infrastructures critiques.

La destruction réputationnelle : l’enseignante mentionnée en introduction met six mois à prouver que la vidéo est fausse. Certains continuent de croire à sa culpabilité. Le mensonge fait le tour du monde pendant que la vérité met ses chaussures.

La post-vérité comme arme politique

« La post-vérité n’est pas l’absence de vérité, mais son insignifiance », écrit la philosophe Myriam Revault d’Allonnes. Quand tout peut être faux, la distinction entre vrai et faux perd de sa pertinence sociale. C’est le triomphe du relativismecomme arme politique.

💡 DÉFINITION : Post-vérité

Situation où les faits objectifs ont moins d’influence sur l’opinion publique que les appels à l’émotion et aux croyances personnelles.

Exemple : Un deepfake viral influence davantage qu’un démenti officiel accompagné de preuves.

Jean Baudrillard parlait d’hyperréalité : cette situation où la conscience ne peut plus distinguer la réalité de sa simulation. Les deepfakes incarnent parfaitement ce concept devenu tangible.

Une nouvelle inégalité sociale

Une fracture se dessine entre ceux qui auront accès à l’éducation numérique critique et les autres. Entre ceux qui pourront se payer des outils de vérification et ceux qui resteront exposés. La vulnérabilité face aux deepfakes devient un nouveau marqueur d’inégalité sociale.

Comment se protéger des deepfakes ?

Face à cette menace, trois réponses complémentaires émergent.

La réponse technologique

Des outils de détection automatique se développent. Ils analysent les micro-incohérences : clignements d’yeux irréguliers, ombres impossibles, légers décalages entre mouvements labiaux et son. Mais ces outils restent toujours un pas derrière les technologies de création. « Nous détectons aujourd’hui 70% des deepfakes », explique une ingénieure spécialisée. « Mais les 30% qui passent sont les plus dangereux. »

La réponse juridique

Des législations émergent, comme le Digital Services Act européen qui impose aux plateformes de lutter contre la désinformation. Mais comment appliquer des lois nationales à des phénomènes transfrontaliers ? Comment punir des acteurs anonymes, parfois soutenus par des États ?

La réponse éducative : la littératie numérique

L’alphabétisation numérique critique devient aussi essentielle que savoir lire et écrire. Cette littératie numérique inclut :

- Le doute méthodique systématique face aux contenus émotionnellement forts

- La vérification par recoupement avec plusieurs sources fiables

- La reconnaissance des signaux d’alerte : contenu qui confirme parfaitement nos biais, absence de source vérifiable, appel à partager rapidement

- La compréhension des mécanismes de viralité et de manipulation

« Nous devons enseigner le doute méthodique dès l’école primaire », plaide un chercheur spécialisé en éducation aux médias. Pas la méfiance paranoïaque, mais la vigilance éclairée.

Conclusion

Les deepfakes ne sont pas qu’une innovation technologique. Ils révèlent une société qui a perdu ses repères de vérité commune. Ils prospèrent dans les fissures de notre contrat social : notre exposition volontaire, nos émotions exploitables, nos algorithmes personnalisés.

La question n’est plus « Pourrons-nous détecter tous les deepfakes ? » mais « Comment reconstruire une confiance collective quand l’évidence visuelle n’est plus fiable ? » La réponse passe par l’éducation critique, la vigilance collective et peut-être une redéfinition de ce que signifie « voir pour croire » au XXIe siècle.

Et vous, comment vérifiez-vous l’authenticité des contenus qui vous parviennent chaque jour ?

📚 POUR ALLER PLUS LOIN :

→ Comprendre l’amnésie collective organisée et ses mécanismes d’effacement → [CRÉER : La surveillance numérique : comment nos données nous échappent] → [CRÉER : L’économie de l’attention : quand notre concentration devient une marchandise]

💬 Partagez cet article pour sensibiliser votre entourage aux dangers des deepfakes.

FAQ

Qu’est-ce qu’un deepfake concrètement ?

Un deepfake est une vidéo, audio ou image générée ou modifiée par intelligence artificielle pour faire croire qu’une personne dit ou fait quelque chose qu’elle n’a jamais dit ou fait. La technique utilise l’apprentissage profond (deep learning) pour analyser des milliers de contenus d’une personne et recréer son apparence ou sa voix de manière hyper-réaliste.

Comment reconnaître un deepfake ?

Plusieurs indices trahissent un deepfake : clignements d’yeux irréguliers ou absents, ombres du visage incohérentes avec l’éclairage, léger décalage entre mouvements des lèvres et son, contours flous autour du visage. Les deepfakes audio présentent parfois des respirations artificielles ou des intonations robotiques dans certaines syllabes. Restez vigilant face aux contenus émotionnellement forts sans source claire.

Pourquoi les deepfakes sont-ils dangereux ?

Les deepfakes menacent la confiance collective en rendant impossible de croire ce que nous voyons et entendons. Ils servent à l’arnaque financière (usurpation d’identité), la manipulation politique (fausses déclarations de dirigeants), le harcèlement (revenge porn), et l’espionnage (infiltration professionnelle). Plus largement, ils installent un doute généralisé qui profite à la désinformation.

Existe-t-il des lois contre les deepfakes ?

Plusieurs pays développent des législations spécifiques. L’Union européenne a intégré les deepfakes dans le Digital Services Act, obligeant les plateformes à les identifier et les retirer. Aux États-Unis, certains États criminalisent les deepfakes pornographiques non consentis et électoraux. En France, la loi contre les manipulations de l’information couvre partiellement les deepfakes. Toutefois, l’application reste complexe face à l’anonymat des créateurs.

Comment me protéger personnellement des deepfakes ?

Limitez votre exposition numérique en réduisant les photos/vidéos publiques de votre visage. Activez les paramètres de confidentialité stricts sur vos réseaux sociaux. Développez une vigilance critique : vérifiez systématiquement les sources, croisez les informations, méfiez-vous des contenus émotionnellement forts. Informez votre entourage sur cette menace. Si vous êtes victime, collectez les preuves, signalez aux plateformes et portez plainte.

Bibliographie

- Baudrillard, Jean. 1981. Simulacres et simulation. Paris : Galilée.

- Benjamin, Walter. 1935. L’œuvre d’art à l’époque de sa reproductibilité technique. Paris : Allia (réédition 2011).

- Cardon, Dominique. 2019. Culture numérique. Paris : Presses de Sciences Po.

- Revault d’Allonnes, Myriam. 2018. La faiblesse du vrai. Ce que la post-vérité fait à notre monde commun. Paris : Seuil.